Шрифт:

Закладка:

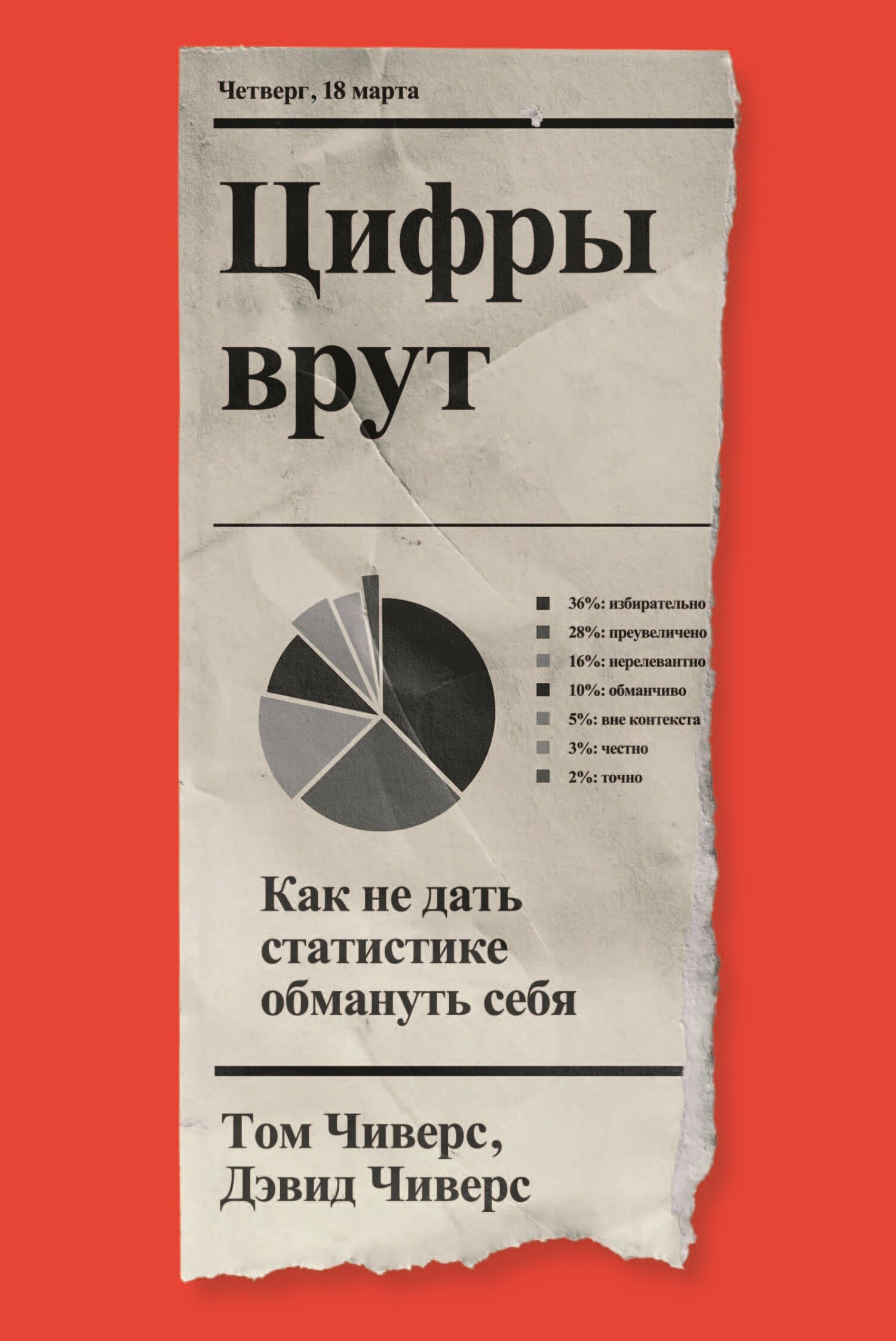

Чтение на ночь сокращает жизнь. Видеоигры провоцируют массовые убийства. Газировка делает людей агрессивными. Что?! Нет!Каждый день медиа пишут о сенсационных открытиях и шокирующих результатах исследований. Но не всем им можно верить: статистические погрешности, намеренные фальсификации и неочевидные огрехи никто не отменял.Из-за пандемии COVID-19 человечество было вынуждено пройти ускоренный курс статистики: теперь мы неплохо разбираемся в графиках, кое-что слышали о нормальном распределении и знакомы с ошибкой выжившего. Но нам еще многое предстоит узнать: как работают математические модели? Чем отличаются абсолютные и относительные риски? О чем говорят рейтинги? Что такое ошибка техасского стрелка? Научный журналист Том Чиверс и преподаватель экономики в Даремском университете Дэвид Чиверс на примерах громких заголовков ковидного времени показывают, как не дать себя обмануть с помощью чисел.В формате PDF A4 сохранен издательский макет книги.